Door Marten van der Meulen

Vorige week schreef ik een blogpost naar aanleiding van een stuk van Marc van Oostendorp (die weer reageerde op een tweet van Geert Wilders). In de post beschreef ik het gebruik van een bepaald woord, difficulteren, aan de hand van een aantal verschillende corpora van het Nederlands. Mijn post bleek op haar beurt aanleiding voor professor Jan Odijk om een post te schrijven over de structuur en interface achter de door mij gebruikte corpora. Het onderzoekje dat ik in twee uur op een dinsdagochtend had uitgevoerd leek daarmee plotseling te worden opgevoerd als rechtvaardiging voor meerdere miljoenenprojecten. Dat is al te veel eer: het was een alleszins triviaal onderzoekje. Maar dit geeft mij wel een mooi haakje om wat kritisch commentaar te geven op deze interface. Vooral op twee punten is er nog een enorme winst te behalen: de kwaliteit van de data is nog aan drastische verbetering toe, en over het type data kan beter worden nagedacht.

Schone data

Laat vooropstaan dat ik zeker niet ondankbaar wil lijken. Wat er al gebeurd is binnen Clariah (zo heet het project achter de interface) is fijn en handig. Zo is een grote hoeveelheid corpora makkelijk toegankelijk binnen Nederlab, en kunnen deze zowel apart als gezamenlijk worden doorzocht met verschillende tools. Je kunt inderdaad vrij complexe zoekfuncties bedenken. Ik was bijvoorbeeld laatst op zoek naar zelfstandig naamwoorden die in het meervoud staan, voorafgegaan door een woord dat eindigt op –tal maar dat níet aantal is (bv. vijftal, honderdtal), en gevolgd door een werkwoord. Dat gaat vrij eenvoudig.

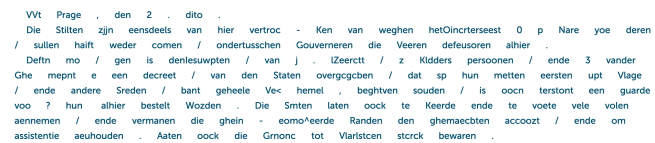

Maar het is dus niet alles goud wat blinkt, ten eerste dus wat betreft de kwaliteit van de data. Men lijkt namelijk toch in de zogenaamde Big Data-val te trappen, waarbij de focus vooral ligt op kwantiteit. Neem het sub-corpus KB Kranten. Dat bevat een ontstellende 10 miljard woorden. Als zodanig is het integraal in Nederlab beschikbaar, en er volgt binnenkort nog minstens zo’n groot aantal woorden. Die omvang heeft bepaalde voordelen. Het zoeken naar zeldzame woorden, zoals difficulteren, wordt makkelijker: hoe meer data, hoe groter de kans dat het woord er een keertje tussen zit. Ook voor het bouwen van taalmodellen is meer data beter. Maar er zitten nog wel wat haken en ogen aan. Zo is een groot deel van de data nog niet opgeschoond. Dan kun je wel zoeken, maar dan zijn je precision en recall zowel onduidelijk als laag. Met andere woorden: je weet niet hoeveel van de totale gevallen van een zoekopdracht je daadwerkelijk te pakken krijgt, en je weet niet hoeveel van de gevallen die je wél krijgt ook daadwerkelijk de juiste zijn. Hoe vies die data is, laat dit voorbeeld uit 1618 zien:

Tsja, dat is nauwelijks leesbaar, laat staan dat je er op kan zoeken. Nu is het verbeteren van dit soort tekstdata een bekend probleem, en het is héél lastig om er met de computer echt goed iets aan te doen (ik schreef er al eerder over). Maar je kunt je afvragen of het dan wel zinnig is om het online te slingeren. Willen we meer slechte data, of minder goede? Mijn mening is duidelijk. Liever minder maar beter. Ik durf best te stellen dat veel onderzoekers het met me eens zullen zijn.

Juiste data

Schone data is dus één van de belangrijkste parameters voor goede data. Het andere belangrijke punt is dat het handig is om het juiste type data te hebben. Mijn onderzoek gaat bijvoorbeeld over grammaticale variatie in het Nederlands in de twintigste eeuw. In het beste geval onderzoek ik die variatie in verschillende genres, waarvan telkens een gebalanceerd sample is genomen, en op basis van een mooie verdeling over de tijd. Dat is vele malen handiger dan een gargantueske bak aan krantendata. Een dergelijk diachroon, multi-genre, gebalanceerd (en schoon) corpus bestaat voor het Nederlands echter niet. En dat terwijl het in principe geen gigantisch innovatieve aanpak vereist: voor het Engels bestaat zo’n soort corpus (het ARCHER-corpus) al sinds 1994.

Het is echter de vraag of dit is waar Clariah voor bedoeld is. Het mission statement van het project stelt namelijk dat het gaat om “het ontwikkelen van een goede, bruikbare, duurzame en gebruiksvriendelijke infrastructuur voor de Geesteswetenschappen.” Het gaat dus niet zozeer om het kiezen van data, als wel om het beschikbaar stellen. Maar kunnen die twee dingen zonder elkaar? Dan krijg je dus heel veel vervuilde data, en er is in ieder geval één onderzoeker die daar weinig mee opschiet. Maar wacht: een ander doel is “to increase our empirical base”. Dat zou weleens een handvat kunnen bieden!

Toekomst

Onlangs werd bekend dat Clariah Plus maar liefst 13,8 miljoen euro krijgt om verder te werken aan de interface. Een bizar bedrag: daar kun je ongeveer 27 promovendi voor aanstellen. Ik hoop dat een deel van dat bedrag wordt ingezet voor het schoonmaken van data. Laat dat nou niet tot het einde wachten, maar geef daar prioriteit aan. Niemand heeft iets aan onbetrouwbare data. Stel dus een stel studentassistenten aan die betrekkelijk handmatig de data opschonen, of maak een makkelijk tooltje voor ze. Zo’n studentassistent kost (volgens mijn snelle berekening) ongeveer €30.000 per jaar. Wanner je er tien (!) aantrekt, heb je nog geen deuk in je budget geslagen. Tien studentassistenten kunnen in een full-time jaar ongelooflijk veel nuttig werk verrichten. Ja, het is niet digitaal, maar dat is nou eenmaal de staat van de techniek. Zolang OCR niet goed werkt moet in ieder geval een deel van het werk handmatig.

En als het even kan: maak gewoon ook wat ruimte voor de creatie van dat grote, diachrone, multi-genre, gebalanceerde corpus. Er zijn echt zat mensen die dat kunnen. Pluk ze weg van BYU, uit Manchester of Leuven, en je hebt binnen een paar jaar een geweldig instrument voor onderzoek naar de ontwikkeling van de Nederlandse taal. De expertise is er, de data is er, het geld is er: nu alleen nog het initiatief.

Dit artikel verscheen eerder op het eigen blog van Marten van der Meulen.

Laat een reactie achter