OpenAI is een bedrijf dat de kracht kent van de angst. Het bedrijf kwam vorig jaar met een taalcomputer, GPT-3, een computer die kan schrijven, en het bedrijf heeft de angst voor die ontwikkeling op subtiele manieren weten te voeden. Worden computers nu echt zo slim dat ze artikelen en verhalen kunnen schrijven die ons meer weten te boeien dan wat er uit mensenbolletjes komt?

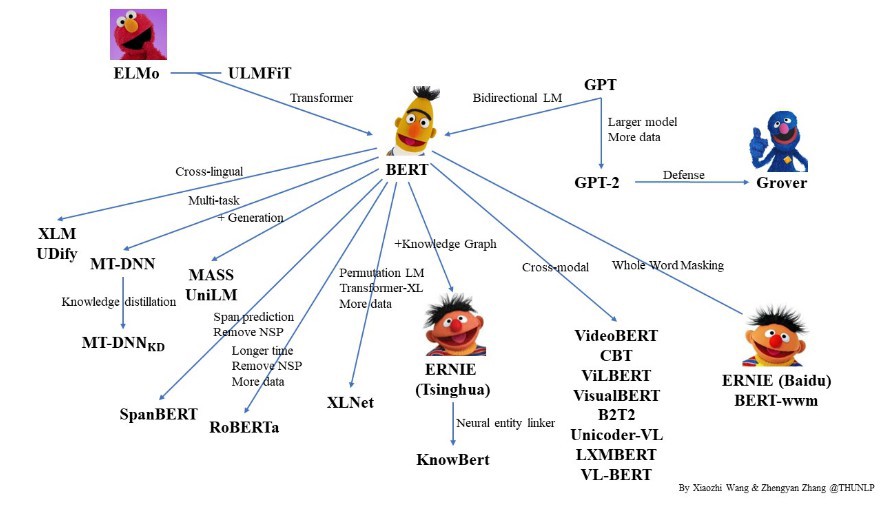

Bij de vorige versie, GPT-2, weigerde het bedrijf een tijdlang geweigerd om de algoritmes vrij te geven omdat dit “te gevaarlijk” zou zijn. Als dit in de verkeerde handen viel, dan ging de doos van Pandora van het geloofwaardige fake news en allerlei andere ellende pas echt open. Een effect daarvan was dat deze modellen pas echt serieus werden genomen. Ik kan me maar niet onttrekken aan de gedachte dat dit precies de bedoeling was van die o zo ethisch lijkende stap. Voor GPT-3 werden de algoritmes sowieso niet meer vrijgegeven, nu niet vanwege de veiligheid maar omdat het bedrijf inmiddels commercieel was geworden.

Racisme

Of al die angst gerechtvaardigd is, weten we niet. Er zijn wel her en der voorbeelden opgedoken van teksten die GPT-3 geschreven zou hebben, en als je betaalt, kun je er ook zelf mee aan de slag, maar dat op een heel beperkte manier: het programma blijft op de servers van OpenAI draaien, je kunt alleen eigen programma’s schrijven die vragen stellen aan dat programma.

Niemand weet dus hoe het werkt. Wat we wel weten: de teksten die OpenAI lijkt te genereren zijn uiteindelijk nogal zielloos. In een interessant artikel in het elektronisch tijdschrift n+1 vergelijkt Meghan O’Gieblyn het met onder hypnose geschreven teksten, of het soort teksten dat de surrealisten wel procuceerden, waarbij ze alle gedachten probeerden uit te schakelen. O’Gieblyn noemt daarbij niet de term écriture automatique, maar dat is wat het is: het onderbewuste lijkt aan het woord, zonder bedoeling, zonder overtuiging, zonder een sturende hand van het bewuste. Gedachteloze gedachten.

Er is weinig om bang voor te zijn, misschien met uitzondering van de najagers van zulke fantasieën. Vorig jaar werd de onderzoeker Timnit Gebru ontslagen bij Google vanwege haar kritiek op Google’s eigen ’taalmodellen’. Het ontslag zorgde vooral voor een schandaal omdat Gebru ervoor waarschuwde dat die taalmodellen racisme, seksisme en andere nare vooroordelen zou reproduceren; er hoeft maar iets te gebeuren of zo’n model, gevoed met de teksten van het internet, begint te brallen. Mij lijkt precies dat verhaal deel van de angst: het is alleen erg als die racistische teksten ook bijvoorbeeld overtuigend werken en dat doen ze nog lang niet.

Energieverspilling

Enigszins onder de radar bleef dat Gebru op basis van onderzoek ook kritiek had op een heel ander aspect: die modellen vreten energie. Om Google’s taalmodel op een redelijke hoeveelheid data te trainen, dus om het een bepaald type tekst te laten schrijven of te laten schrijven als één bepaalde schrijver, is er meer energie nodig dan om van New York naar Chicago te vliegen. (Ook wat dat betreft kun je beter een menselijk hoofd hebben.) Er is nu sprake van dat OpenAI volgend jaar met een nieuw taalmodel komt (vol fantasie GPT-4 genoemd), dat 500 keer groter is dan GPT-3. In de zoektocht naar een computer die een onderzoeksverslag kan schrijven in het Engels is dat allemaal geoorloofd. (En let wel: dit gebeurt dus, zolang de algoritmes geheim zijn, niet met een beroep op de vermeerdering van kennis en de wetenschap, maar alleen voor commercieel gewin.)

Op zijn minst sinds de tijden van Lernout en Hauspie of die van Bob Mercer kleeft de taaltechnologische industrie een wat bedenkelijk imago aan – een imago waar de beoefenaren van het vak wat mij betreft zich veel te weinig over hebben drukgemaakt. Zolang ik het vak volg, en dat doe ik al 35 jaar, is er de belofte dat de grote doorbraak nu toch echt om de hoek ligt, omdat de computers nu nog sneller zijn geworden, niet omdat de ideeën beter zijn geworden.

Voortdurend worden er daardoor angstverhalen aangewakkerd van computers die binnenkort onze intellectuele taken gaan overnemen. De feitelijke resultaten vallen altijd tegen, maar dat valt nooit op, omdat op het moment dat de evaluatie zou kunnen komen van al die grandioze claims er gewoon weer nieuwe angstverhalen komen over wat de computers over 10 jaar dan wél allemaal zouden kunnen.

Ik zou zeggen is dat het tijd is dat de samenleving zich uitspreekt over de vraag of het zulke schadelijke, energie-verspillende industrieën wel wil verdragen.

Natuurlijk is er soms sprake van hype, en de discussie rond GPT-3 is hier een goed voorbeeld van. Maar om nu zulke modellen, of zelfs het hele vakgebied, om die reden af te schrijven gaat wel wat ver. Wat je verder ook van neurale taalmodellen vindt, ze werken wel beter dan wat we tot nog toe hadden.

Marco Baroni en anderen schreven bv in 2014 al een artikel (https://www.aclweb.org/anthology/P14-1023.pdf) dat leest alsof ze zelf ook niet erg in neurale modellen geloofden, maar tot hun verbazing moesten constateren dat op alle tests voor woord-associaties de neurale aanpak het won van 30 jaar zorgvuldig statistisch modelleren. Zelf overkwam ons zoiets toen we rond 2017 moesten constateren dat er verschillende teams waren die als onderdeel van een ‘shared task’ in ‘universal dependency parsing’ scores behaalden op automatische syntactische analyse van Nederlandse zinnen die hoger waren dan wat Alpino presteerde (http://universaldependencies.org/conll17/evaluation.html). En Alpino was toch gebaseerd op meer dan twintig jaar zorgvuldig taaltechnologisch werk en maakt gebruik van een zeer gedetailleerde grammatica voor het Nederlands. Wanneer dan een groep in Azie waar je tot dan toe nooit van gehoord had in staat blijkt dit probleem beter op te lossen dan wij vraag je je toch wel even af in hoeverre expliciete taalkundige kennis nodig is voor syntactische annotatie.

Nu zijn dit onderwerpen waarvan de betekenis buiten de taaltechnologie niet zo duidelijk zal zijn, maar op het gebied van automatische spraakherkenning en automatisch vertalen is wel degelijk veel vooruitgang geboekt. Er gaat nog steeds veel mis, maar evaluaties laten toch zien dat neurale taalmodellen hier veel beter werken dan de technologie van 10-15 jaar geleden. Claims dat automatisch vertaalde teksten in bepaalde domeinen niet meer te onderscheiden zijn van vertalingen die door vertalers zijn gemaakt zijn misschien wat overdreven (https://arxiv.org/abs/1803.05567), maar het feit dat serieuze onderzoekers hierover beginnen toont toch aan dat er vooruitgang wordt geboekt.

En over het imago: er zijn een aantal onderzoekers die al veel langer waarschuwen voor de schadelijke effecten van overdreven optimistische verhalen in de pers, de ACL heeft tegenwoordig een ethische commissie, en ook de grote conferenties beoordelen inzendingen naast wetenschappelijke kwaliteit tegenwoordig op ethische aspecten (https://2021.aclweb.org/ethics/Ethics-FAQ/) .

Tenslotte: je kunt natuurlijk teleurgesteld zijn dat de directe rol van taalkundige theorie binnen de taaltechnologie afneemt, maar ondertussen is er ook een hele cottage industry ontstaan van onderzoekers die zich afvragen in hoeverre zulke modellen bijvoorbeeld gevoelig zijn voor syntactische structuur, zoals die bijvoorbeeld nodig is om subject-verb agreement juist te voorspellen, ook in lastige contexten, of zelfs in hoeverre zulke modellen gevoelig zijn voor island-constraints voor extractie van WH-woorden. (https://www.annualreviews.org/doi/abs/10.1146/annurev-linguistics-032020-051035) Zelf onderzocht ik bijvoorbeeld in hoeverre BERT-modellen voor het Nederlands in staat zijn het juiste betrekkelijke voornaamwoord (die of dat) te voorspellen in zinnen waar je als lezer ook moet beslissen of we hier met ‘hoge’ of ‘lage’ aanhechting van een betrekkelijke bijzin te maken hebben (“Melk is het enige product van de koe DIE/DAT aan de paniek is ontsnapt”). Naar de voorkeur van proefpersonen voor hoge of lage aanhechting in verschillende talen is veel psycholinguistisch onderzoek gedaan. De taaltechnologische variant van zo’n experiment laat zien dat deze modellen zeer goed in staat zijn de juiste voorspelling te doen, en bovendien dat ze dat doen door informatie uit de hele zin te combineren en niet slechts door naar de voorafgaande zelfstandige naamwoorden te kijken, of naar het hoofdwerkwoord in de bijzin. (https://github.com/gossebouma/die_vs_dat). De conclusie van al deze ‘probes’ is dat deze modellen, die alleen maar getraind zijn op platte tekst en geen enkele vorm van taalkundige annotatie, toch een antenne ontwikkelen voor niet-triviale aspecten van de zinsbouw.

Zie ook dit recente stuk van (daar is hij weer) Marco Baroni, iemand die zich met beide kanten van het verhaal heeft bezig gehouden, over het grote gat dat ontstaan is tussen de theoretische taalwetenschappen en de taaltechnologie: https://ling.auf.net/lingbuzz/006031

Dankjewel, Gosse en Jelke, voor deze reacties. Ik ga het allemaal lezen!

zoals bij alle onderzoek geldt de metafoor van de bijl: als de steel los zit, ga dan niet vol vertrouwen met de bijl hakken. Houdt het als belangrijk terrein van onderzoek. Het internetgebied toont al scheuren door te snelle en ongecontroleerde uitbreidingen.