Toen ik vorige week ChatGPT het vwo-examen had laten maken, vroegen sommige mensen zich af waarom ik de gratis toegankelijke versie (3.5) had gepraat, in plaats van de betaalde (4.0), die veel beter is. Ik wilde juist testen hoeveel gratis antwoorden je nu kunt krijgen met voor iedere toegankelijke software, maar inmiddels heeft Jos Mulder de teksten voor me door de nieuwe versie gehaald, en inderdaad: die is veel beter. In plaats van 33 van de 60 punten, haalt de nieuwe versie het examen ruimschoots, met 50 van de 60 punten.

Nog meer dan bij de goedkope versie zitten de paar problemen die er zijn nog niet eens zozeer in kunnen aanduiden hoe de tekst in elkaar zit, als wel in het begrijpen van de conventies van een tentamen. Teksten met elkaar vergelijken gaat mis, maar mogelijk vooral omdat de eerste tekst vergeten is als de vragen over de tweede tekst gesteld zijn. Een ander probleem is dat ChatGPT niet goed kan tellen – heel opmerkelijk voor een computer – en te lange antwoorden geeft. Als er een limiet is van bijvoorbeeld 30 woorden, gaat ze er ruimschoots overheen. Bij het corrigeren mag je dan alleen naar de eerste 30 woorden kijken en daar zit het goede antwoord soms net niet in. (Het examen staat hier; de antwoorden van ChatGPT 3.5 hier, en de ‘nieuwe’ antwoorden van ChatGPT 4.0 hieronder.)

Waar dit allemaal toe leidt? Dat is volkomen onduidelijk. Ik geloof niet dat er een jaar geleden iemand zou hebben gedacht dat er nu een computer zou zijn die het eindexamen kan maken. We zijn echt een nieuw tijdperk binnengetreden.

Het is, lijkt mij, ook op zich ook geen argument om het examen meteen anders in te richten. Natuurlijk wordt de discussie of dit examen nu echt tekstbegrip meet verscherpt, omdat chatbots op een bepaalde manier niet écht lijken te begrijpen wat ze wordt voorgelegd en waarop ze goed antwoorden. Maar die discussie is heel filosofisch en zolang we geen alternatieve toetsen hebben die ‘echt’ begrip meten en goed worden gemaakt door mensen en niet door bots, weten we ook niet wat de praktische consequenties precies zijn.

Je mocht als kandidaat al geen telefoon gebruiken, en die regel kan blijven staan. Wel zou je al voorzichtig kunnen nadenken of we het systeem niet kunnen gebruiken als hulpje bij de correctie – een enorm tijdrovende klus die natuurlijk eigenlijk helemaal niet bij docenten thuishoort. Als de computer de antwoorden kan vinden, kan ze die misschien ook beoordelen. Op dit moment durven we die correctie nog niet helemaal toe te vertrouwen aan de computer, maar ze zou misschien als tweede corrector kunnen optreden, om te zien of de eigenlijke docent het werk goed heeft gedaan.

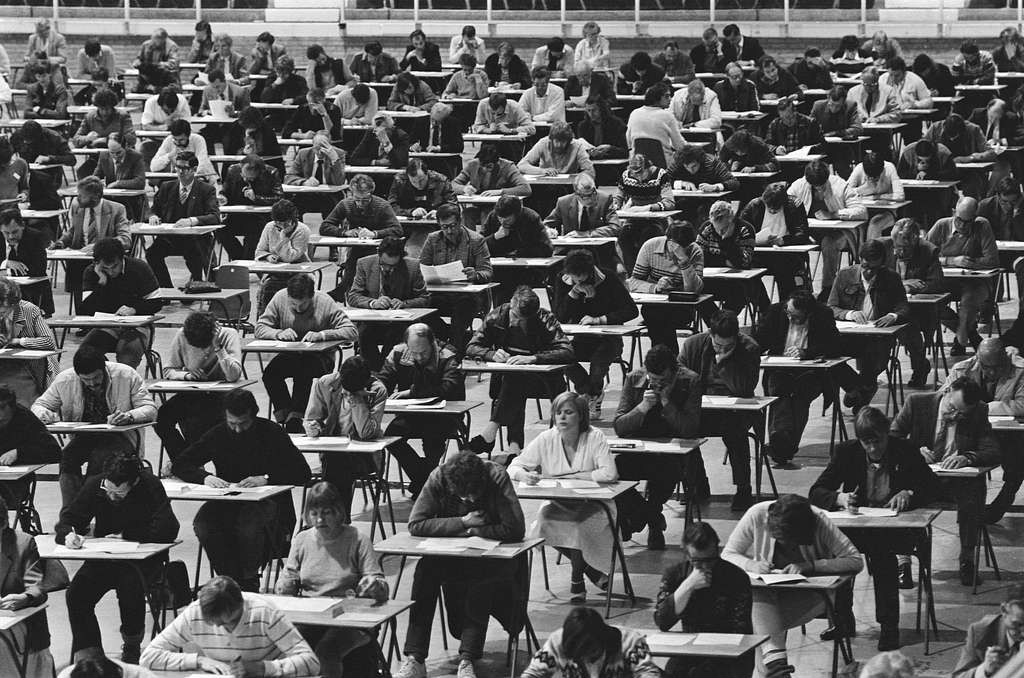

Een volgende stap – daar moeten we nog wel wat versies verder voor zijn – zou kunnen zijn dat ChatGPT de examens zelf maakt. Dan kan iedere leerling een op maat gesneden examen maken, op een zelfgekozen moment. Weg met de gymzalen!

Maar tegen die tijd zijn we vermoedelijk aanbeland bij een stadium in de discussie waarbij we ons afvragen waarom je eigenlijk nog opinieteksten zou lezen als die zo kundig door de computer kunnen worden samengevat en becommentarieerd.

Laat een reactie achter