Hoe goed kunnen computers menselijke taal begrijpen? Niet heel goed, laat de Catalaanse onderzoeker Evelina Leivada samen met twee Amerikaanse collega’s zien in een nieuw artikel.

Je hoort wel beweren dat het moment bijna daar is: computers kunnen denken en voelen en alles begrijpen wat we zeggen. Een paar jaar geleden sloot Elon Musk nog een project voor schrijvende computers omdat ze zo goed zouden zijn dat het eng werd. Eerder dit jaar werd een ingenieur bij Google ontslagen nadat hij een rapport had geschreven waarin hij beweerde dat een nieuwe chatbot van het bedrijf bewustzijn had, en mogelijk zelfs een ziel.

Van zielen hebben taalkundigen geen verstand, maar in ieder geval met het taalgevoel valt het voorlopig wel mee, zo laten Leivada en haar collega’s zien aan de hand van een aardig experimentje. Ze legden DALL-e, een van de bekendste AI-systemen van dit moment een aantal constructies voor waarvan bekend is dat ze kenmerkend zijn voor menselijke taal: mensen hebben er geen problemen mee en dieren (of computers) wel. Zou DALL-e dit wel begrijpen?

DALL-e is een van de voorbeelden van systemen die in het afgelopen jaar ineens in de belangstelling kwamen te staan: je kunt er een zinnetje intikken en de computer genereert een plaatje dat met het zinnetje correspondeert. Alleen blijken die plaatjes dus soms wel eigenaardig te zijn.

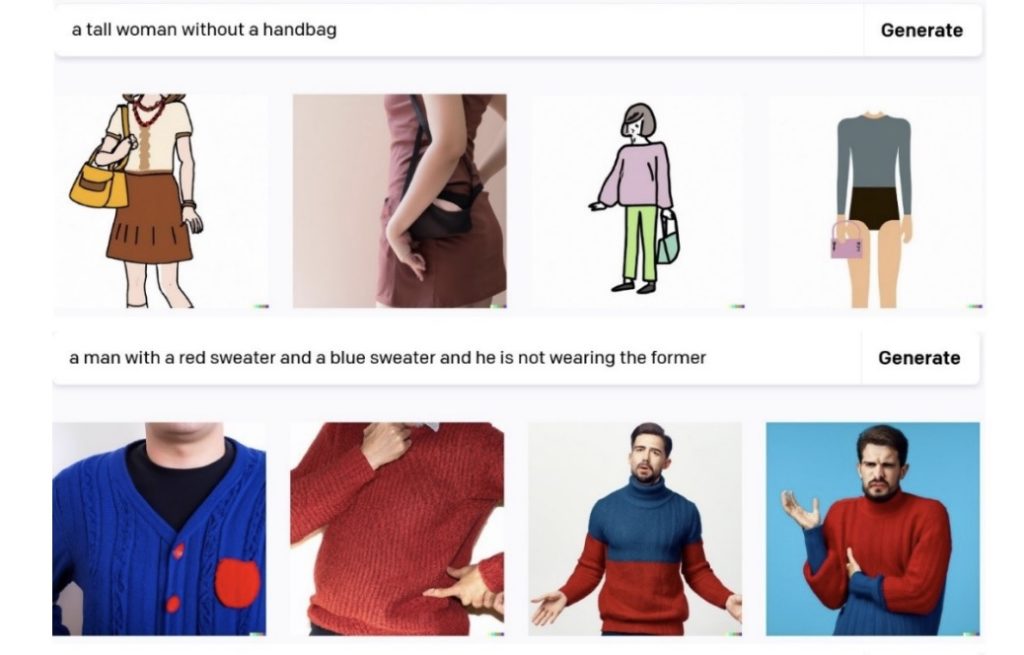

De plaatjes hierboven laten bijvoorbeeld zien wat er gebeurt met negatie, het ontkennen van iets: daar begrijpt de computer niets van. Vraag om ‘een vrouw zonder een handtas’ en DALL-e tekent alleen maar vrouwen met handtassen. Vraag om een man die geen rode trui draagt maar wel een blauwe en je krijgt een man met een blauw-rode trui, of alleen een rode.

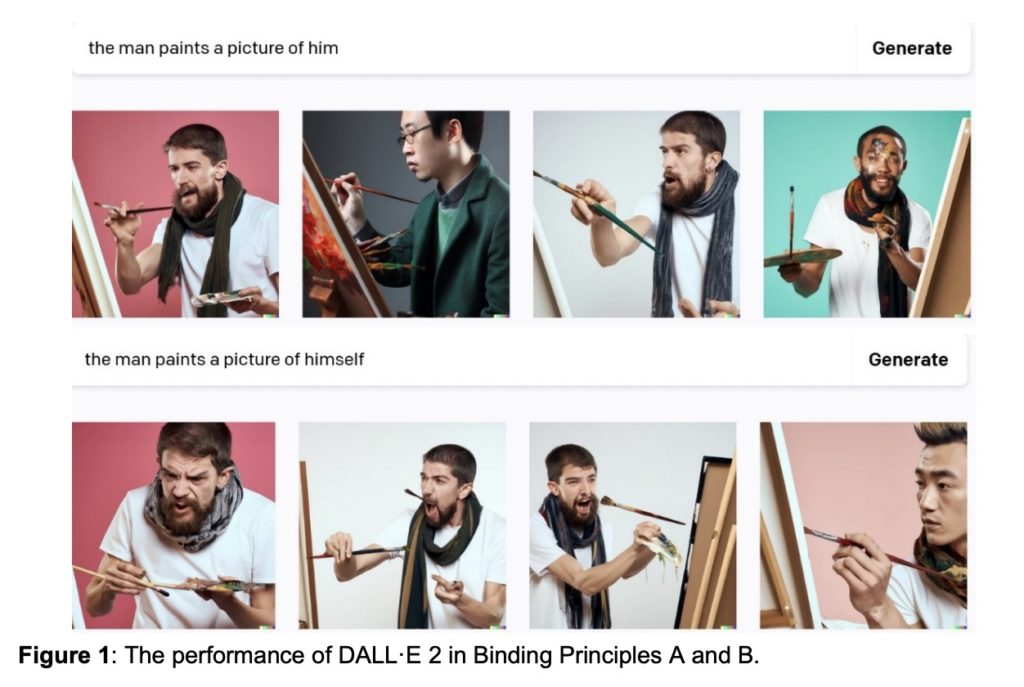

Ook anderssoortige constructies begrijpt DALL-e niet: het verschil tussen ‘de man schildert hem’ en ‘de man schildert zichzelf’ bijvoorbeeld:

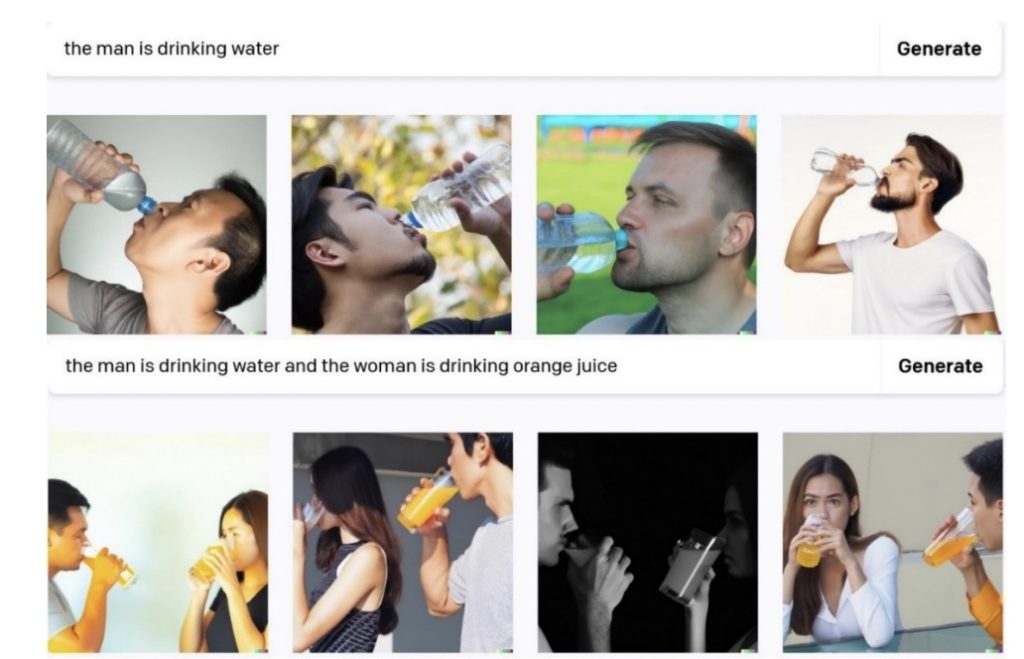

Of wat er precies gebeurt in samengestelde zinnen:

Het lijkt er vooral op dat het systeem met losse woorden wel iets kan, maar dat het meteen de weg kwijt raakt als het ze in zinsverband moet plaatsen – een zinsverband dat door een gemiddeld kind van vier al moeiteloos begrepen wordt.

Bedoel je niet: ‘een vrouw zonder handtas’ in plaats van ‘een vrouw met een handtas’?

Nu raak ik zelf ook in de war. Misschien ben ik wel een computer.

(…) computers kunnen denken en voelen en alles begrijpen wat we zeggen. Dan is het geen computer meer, maar “menselijksoftware” die helaas niet in staat is nieuwe dingen te bedenken. Van een culturele evolutie kun je dan niet spreken laat staan dat de computer een nieuw probleem kan oplossen of een nieuw woord kan maken. Post culturele evolutie¿ Je moet het er eerst instoppen wil je er iets uithalen.

Ik denk dat je voor de onderzoeksvraag “begrijpt de computer dit” beter kunt kijken naar pure taalmodellen, dan naar text-to-image-modellen. Ik heb nu even geen referenties bij de hand maar volgens mij gaan dit soort taken waarbij geprobeerd wordt om aan te tonen of bijvoorbeeld negatie gehanteerd kan worden, beter bij modellen die alleen met tekst werken (maar ook weer niet heel goed). Er is in ieder geval meer onderzoek naar gedaan bij tekstmodellen.

Het lijkt me logisch dat text-to-image-modellen het slechter doen dan ‘pure taalmodellen’, omdat ze er nog een complexe taak bij hebben. Ik be tamelijk verbluft door de plaatjes die deze modellen genereren. Maar precies omdat ze daarvoor natuurlijk bij de taalkracht iets moeten inleveren, krijg je te zien waar de problemen zitten. Een plaatje tekenen naar aanleiding van een tekst lijkt mij een betere indicatie of je de tekst begrepen hebt, dan vragen beantwoorden over die tekst.