Een opmerkelijke trend in het hedendaagse cognitief wetenschappelijk onderzoek, wereldwijd, met name op het gebied van taal is dat Big Data, ‘large language models’ (LLMs), en ‘deep neural networks’ (DNNs) breed worden uitgemeten als AI-oplossingen voor kernproblemen als het menselijk taalvermogen en kindertaalverwerving. En dit jaar is de Nobelprijs voor Natuurkunde zelfs toegekend aan de grondleggers van AI, Geoffrey Hinton en John Hopfield. Zij krijgen die prijs voor de ontwikkeling van computationele modellen voor patroonherkenning in datasets met behulp van artificiële neurale netwerken. Het is waar dat deze modellen ook normaal taalgebruik steeds beter en realistischer benaderen. Maar wat betekent dit precies? Een experimenteel-statistische benadering van een astronomische verzameling van willekeurige of niet-geanalyseerde data betekent op zich weinig. Dat komt omdat meer en meer data en een steeds betere statistiek vanzelfsprekend altijd weer betere benaderingen zullen opleveren. Het is een vorm van succes die zichzelf bevestigt maar weinig verklarende waarde toevoegt. Wèl meer productie en betere predictie van taal op grond van krachtiger probabilistische modellen (Bayesiaanse statistiek) maar géén verklaring van het interne systeem, die wèl volgt uit biologisch realistische taalmodellen. Een technologische prestatie, maar geen model van taal in het brein.

Onlangs verscheen er in Behavioral and Brain Sciences een themanummer, Deep problems with neural network models of human vision (Bowers et al., 2023). De auteurs noemen een aantal empirische missers, experimentele fouten en principiële redenen voor het falen van DNNs als modellen voor optische herkenning en categorisatie van objecten. In het commentaargedeelte vinden we een reactie van Bever, Chomsky, Fong en Piattelli-Palmarini (2023) met als titel Even deeper problems with neural network models of language. Zij leggen uit waarom DNNs principieel slechte taalmodellen zijn voor het menselijk brein. DNNs/LLMs zijn geen modellen van organische systemen en verklaren niet hoe een kind in zeer korte tijd een rijke taalkennis ontwikkelt op basis van heel mager, beperkt en soms gebrekkig of defect taalaanbod (poverty of the stimulus). De aard en omvang van het kindgericht taalaanbod, de aard en duur van het leerproces, de verwerking van de data, alles is anders in de empirische werkelijkheid van het taallerend kind.

Zo wordt bijvoorbeeld GPT3 getraind op een 45-terabyte tekst corpus en produceert zij tekst die (uiteindelijk) misschien de Turing-test kan halen. Het kunstmatig neuraal netwerk kent 175 miljard parameters, ongeveer tweemaal het aantal hersencellen, en kent 96 lagen (de 100 biljoen parameters van GPT4, benaderen zelfs het totale aantal synaptische verbindingen, geschat op 100 tot 1000 biljoen, in het menselijk brein). Woorden worden aangeboden in “batches” van ongeveer 3 miljoen. De leersnelheid is zo laag dat elk woord tienduizenden keren moet worden aangeboden. Een biologisch onwaarschijnlijk backprop leeralgoritme.

Taal ontwikkelt zich zonder incrementele inductie. We weten dat kinderen al vanaf het eerste moment dat ze getest kunnen worden hiërarchische structuur kennen en dat zij meer begrijpen dan wat ze kunnen produceren. Kinderen verwerven hun taal zonder training of instructie en op basis van soms spaarzaam taalaanbod. Dat doen ze met een betrekkelijk langzaam werkend “chemisch brein.” Deze poverty of the stimulus wordt overbrugd door een domein-specifiek en universeel menselijk taalvermogen (UG). LLMs daarentegen werken met astronomische hoeveelheden data en leren opportunistisch met een snelwerkend “elektronisch brein” op basis van een enorme aantal training sessies. Zij volgen hierbij een soort van abductieve redenering naar de best mogelijke oplossing. Geen plausibel mechanistisch model voor een neurobiologisch realistisch taalontwikkelingsmodel.

Alles wat we weten over menselijke taal (discrete infinity, structuurafhankelijkheid, binaire hiërarchische structuur, de rol van computationele eenvoud, poverty of stimulus) staat haaks op wat DNNs ons vertellen wanneer zij taal-theoretische inzichten uit de weg gaan. Taal kent hiërarchische structuur terwijl probabilistische DNNs (die zich met name baseren op dependency grammar of construction grammar) de lineaire structuur van woordreeksen als input krijgen. Recent statistisch onderzoek naar taalverwerving van Charles Yang en collega’s maakt ook duidelijk hoe de spaarzaamheid van beschikbare data (‘de lange staart van Zipf’s Law’) een ‘search space’ (UG) van mogelijke talen impliceert (Yang, 2016; Yang et al., 2017).

Meer fundamenteel, de aangedragen LLM-oplossingen kunnen geen verklaringen van empirische problemen zijn zoals die van theoretische modellen omdat de verkeerde vraag gesteld wordt. LLMs werken voor mogelijke talen net zo goed als voor onmogelijke talen. Het is een ontwerpfout van deze systemen. In tegenstelling tot menselijke taalverwerking presteren LLMs bijvoorbeeld even goed op een mogelijke tekst (ik ga naar …) als op een gespiegelde onmogelijke tekst (… raan ag ki) bij het voorspellen van het volgende woord (Luo et al., 2024).

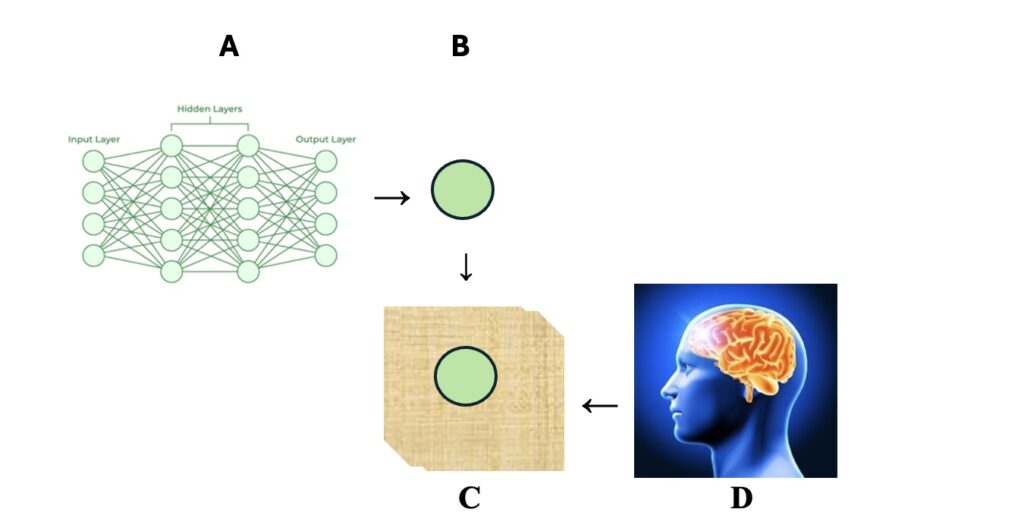

Menselijke talen zijn begrensd. Niet alles kan. Dus zonder inzicht in wat wel en wat geen menselijke taal kan zijn kunnen we weinig inzichtelijks zeggen over het menselijk taalvermogen en taalverwerving. Statistische correlaties kunnen nooit de plaats innemen van causale verklaringen. LLMs werken op eindige datasets, ook al zijn deze gigantisch groot, maar zoekmachines zien geen data die er niet zijn. Ze werken steeds beter maar geven niets wat al niet in de databank zit. Een simpel voorbeeld. Contractie van ‘dat’ en ‘is’ tot ‘das’ zoals in “da’s fijn” zal in voorkomende gevallen juist ‘voorspeld’ worden. Maar de onmogelijke contractie in “weet jij wat da’s?” of het subtiele contrast tussen “ik weet niet zeker of da’s gezegd” (onwelgevormd) en “ik weet niet beter of da’s gezegd” (welgevormd) is een andere zaak. Het eerste voorbeeld komt hoogstwaarschijnlijk in geen enkele dataset voor. Maar het systeem kan niet zeggen of dit onwelgevormd is alleen omdat het niet voorkomt. Het minimale paar “niet beter/zeker weten of” komt misschien ook niet voor maar de asymmetrie is significant. Een ander voorbeeld. Ontkenningen van collectiverende (‘universele’) voornaamwoorden/bijwoorden of nevenschikking zoals nalles , noveral, naltijd of het Engelse nand komen in geen enkele taal voor in tegenstelling tot ontkenningen van ‘existentiële’ tegenhangers als niets, nergens, nooit of het Engelse nor (Huybregts, 1979; Horn, 1989). Niet alleen zijn ze onvindbaar voor LLMs, een verklaring voor deze taaluniversale valt principieel buiten het bereik. DNN/LLM zijn dus allesbehalve een simulatie van het menselijke taalvermogen (Figuur 1).

LLM zal asymmetrische verhoudingen zoals deze niet boven tafel krijgen omdat de ‘onmogelijke’ data vaak onvindbaar blijven. Onvindbaar want algemeen onbestaanbaar. Meer principieel, ook de onmogelijkheden in taal zijn oneindig, en een oneindig corpus van onbestaanbare onmogelijkheden is uitgesloten. Zonder scherpe afbakening van een zoekruimte zal een probabilistische aanpak nooit een model opleveren van wat een mogelijke en wat een onmogelijke taal is (Moro, 2016). Dit verschil tussen syntactische regels die echt/mogelijk en onecht/onmogelijk zijn heeft werkelijkheidswaarde en kent een neurologische onderbouwing. Echte regels activeren gebieden in het brein die neurologische verwerking van taal laten zien; onechte regels activeren allerlei gebieden die normaal alleen voor algemene probleemoplossing worden gebruikt. Dit resultaat van Moro en collega’s uit Nature Neuroscience (Musso et al., 2003) was zelfs de moeite waard om opgenomen te worden in het meest prestigieuze handboek van de neurowetenschappen, Principles of Neural Science, van de Nobel Laureaat voor Fysiologie 2000 (Kandel, 2021). Bij mijn weten is dit nooit een aandachtspunt geweest in enige wetenschapsbijlage van Nederlandse kranten, evenmin overigens als het werk van Charles Yang over Zipf’s Law.

DNNs/LLMs zijn een slimme, geavanceerde tool met ingenieuze praktische chatbot applicaties die mogelijk de Turing-test doorstaan maar zijn geen model dat ons taalvermogen zal verklaren. Zelfs met Turing-compleetheid zijn LLMs/DNNs geen theorie van het menselijk taalvermogen of van kindertaalverwerving net zomin als een universele Turing Machine dat is. LLMs/DNNs maken geen onderscheid tussen mogelijke en onmogelijke talen en vertellen ons dus niets over taal. We verwachten dat — anders dan voor ons — een nalles/*niets-taal even ‘leerbaar’ zal zijn voor LLM/DNN als een *nalles/niets-taal. Als er maar genoeg data zijn, zullen de ‘onmogelijke’ patronen ontdekt worden die mensen zich niet op een natuurlijke manier eigen kunnen maken zoals kinderen hun taal verwerven. Mensen zullen dit alleen oplossen in een ‘problem-solving’ modus (Musso et al., 2003), niet als een taalkwestie, zoals neurologisch onderzoek naar verwachting zal aantonen.

Wel is het zo dat deze LLM-modellen normaal taalgebruik steeds beter benaderen met vaak fabuleuze nauwkeurigheid. Ze geven echter geen causale verklaring. Ze kunnen ook niet aangeven hoe waarschijnlijk iets niet voorkomt. Er zijn geen databanken over alle niet-voorkomende data. Statistisch-gebaseerde correlaties lijken het hoogst haalbare terwijl causale verklaring van empirische data of puzzels en experimentele bevestiging of ontkrachting primaire doelstellingen zouden moeten zijn. Deze urgentie wordt steeds vaker niet meer gevoeld in de cognitieve wetenschappen, die meer en meer geïnteresseerd lijken in taalgebruik en AI-technologie. De belangstelling gaat daarom steeds meer richting simulatie van menselijke taalproductie en verlaat de weg van de biolinguïstiek, verklaring van biologische systemen die onderliggend zijn aan taalverwerving en taalverwerking. Taaltechnologie stelt geëxternaliseerde taal (taalgebruik, een vorm van verbaal gedrag) centraal. Het bestaan van geïnternaliseerde taal (taalbezit, een cognitief systeem gecodeerd in het brein) wordt als perifeer gezien of zelfs ontkend. Ted Gibson, nota bene een cognitief wetenschapper aan het MIT, is zo’n zelfbenoemd empirist, net als Ev Fedorenko en Steven Piantadosi.

Deze hype wordt wereldwijd bijna blindelings gevolgd in podcasts en wetenschapsbijlagen van kranten. Een zeer recent maar onschuldig voorbeeld van Big Data en corpus statistiek zien we in het NRC stuk “De ene taal is de andere niet” van Berthold van Maris (W4, zaterdag 2 november 2024). Deze wetenschapsbijdrage bespreekt Grambank, een taalproject van het Leipziger Max Planck Instituut voor Evolutionaire Antropologie, waar Hedvig Skirgård en collega’s in een Science Advances artikel (Hedvig Skirgård et al., 2003) uitvoerig over publiceerden. Het stuk schetst een beeld van de verscheidenheid van taal en geeft mogelijk een paar interessante voorbeelden voor een breder lezerspubliek.

Grambank is een databank. Maar liefst 2467 talen, inclusief 37 dialecten, worden vergeleken op 195 grammaticale eigenschappen (‘parameters’). Het is Big Data, geen LMM of taalmodel maar een database die beschrijving en (soms) voorspelling mogelijk maakt maar niets verklaart. Een vraagbaak en niet meer. De typologische generalisaties die hier statistisch uit zijn af te leiden zijn correlatief. Causale verklaringen zijn onbereikbaar omdat een theoretisch kader ontbreekt. Dit wezenlijke punt wordt echter niet gemaakt. Wetenschappelijk inzicht eist verklaring, geen beschrijving. Daarmee rijzen er onmiddellijk twee vragen.

Er is uitstekend modern onderzoek naar parameters van Ian Roberts (Cambridge University) en van Giuseppe Longobardi en collega’s (York University) van de laatste vijftien jaar. Belangrijke bijdragen zijn Longobardi & Guardiano (2009, 2016), Ceolin et al. (202o, 2021) en Irimia et al. (te verschijnen). Deze studies gebruiken een parametrisch vergelijkingsmodel om diepe historische verwantschap bloot te leggen. Zij brengen parametrische taalverschillen in kaart en leiden de Manhattan-afstanden en genealogieën van talen en taalfamilies af binnen een restrictief taal-theoretisch kader, het Principles & Parameters model van Chomsky (1981). Roberts (2019) concludeert dat de parameters zelf geen deel uitmaken van UG maar voorspelbaar verschijnen in de loop van taalverwerving. Het onderzoek van Longobardi en zijn team gebruikt momenteel 94 parameters en 58 talen in de context van een restrictieve Universele Grammatica die empirisch aansluit bij een realistisch model van taalverwerving. Het is teleurstellend dat dit origineel werk noch in het Science artikel noch in het NRC stuk wordt genoemd of besproken.

De tweede vraag raakt aan het verschil beschrijving vs. verklaring. De vraag werd onderzocht of de complexiteit van werkwoorden en die van zelfstandig naamwoorden in taalfamilies omgekeerd evenredig zouden zijn. Het antwoord van Grambank was teleurstellend, soms wel en soms niet, en weinig inzichtelijk. Maar dit soort vragen kan preciezer vorm worden gegeven in theoriegericht generatief taalonderzoek en laat zich eenvoudig als volgt illustreren. In natuurlijke taal kan getalsaanduiding op zowel het naamwoord als het verbogen werkwoord zitten, op de één maar niet op de ander, of op géén van beide. Dus vier logische mogelijkheden. Maar het belangrijke punt is dat er maar drie opties empirisch voorkomen. Getal op beide (Italiaans), op alleen het naamwoord (Afrikaans), op geen van beide (Chinees). Getal alleen op het werkwoord ontbreekt. Waarom? Toevallig of principieel? Grambank zal dit onmogelijk oplossen en geeft hooguit een correlatieve opsomming (“als het werkwoord getal heeft, heeft het naamwoord dat ook”). Voor een verklaring waarom deze vierde optie een ‘onmogelijke taal’ impliceert heb je een theorie nodig. Het goede nieuws is dat die er is. Maar niet in Leipzig.

Dergelijke clusters van samenhangende parameters die structurele asymmetrieën inhouden zijn vaak nuttig omdat ze leiden tot wezenlijke vragen over het taalsysteem zelf. We vinden ze wereldwijd en ze doen zich ook voor binnen één enkele taal. Een voorbeeld hiervan is het Turks. Het Turks kent getalsovereenkomst tussen onderwerp en verbogen werkwoordsvorm (1) maar drukt deze relatie liever uit als in (2). Het getal zit al opgesloten in het naamwoord. Getal op het werkwoord is ‘redundant’ en wordt hier liever weggelaten.

(1) adam-lar öl-dü-ler (?*)

man-PL sterf-PST-PL

“de mannen stierven”

(2) adam-lar öl-dü (ok)

man-PL sterf-PST

“de mannen stierven”

(3) adam öl-dü-ler (*)

man sterf-PST-PL

“de mannen stierven”

Maar waarom is dan (3) uitgesloten, waar de redundantie op de andere kant wordt weggewerkt? Dezelfde vraag, hetzelfde antwoord. Sommige kenmerken hebben een semantische functie en andere hebben een grammaticale functie. We hebben Jan at appels (“Jan heeft ’n keer meer dan één appel gegeten”) maar niet Jan aten een appel (“Jan heeft meer dan één keer ’n appel gegeten”). Grammaticale functies hebben geen semantische duiding en moeten afgevinkt worden door een functie met semantische inhoud (‘validatie’). Ze dienen een syntactisch doel, hier het faciliteren van een compositionele subject-predicaat relatie. Net als bij het probleem hierboven mankeert het niet-interpreteerbare getalskenmerk op het werkwoord in (3) een interpreteerbaar getalskenmerk op het naamwoord. Dat laatste is nodig om een syntactische verband, namelijk het labelen van subject-predicaat structuur, noodzakelijk voor semantische interpretatie, af te dwingen. Afwezigheid van dit semantisch kenmerk leidt tot een ‘crash,’ waarmee de ongrammaticaliteit in beide gevallen verklaard is. Congruentie (‘agreement’) garandeert de labeling, en die laatste zorgt voor een convergerende derivatie.

Er zijn wel talen met een morfologisch suffix op het werkwoord waarmee een verschil kan worden aangegeven tussen “Jan at ’n keer een appel” en “Jan at meerdere keren ’n appel.” Maar het suffix van deze ‘pluractionele’ werkwoorden heeft een semantische, geen grammaticale, functie en geeft de menigvuldigheid (iteratief, distributief) van acties aan, niet een congruentie met het subject/object. Een ander verhaal dus.

De verklaring wordt bevestigd door ‘possessive agreement’ tussen het genitiefnomen en het bezitsnomen in “het huis van de mannen” in (4). Dit alles volgt zonder stipulatie uit een taalmodel dat gebaseerd is op de Strong Minimalist Thesis (SMT) van Chomsky, (2021).

(4) adam-lar-ın ev-i

man-PL-GEN huis-3

“het huis van de mannen”

(5) adam-ın evi-ler-i

man-GEN huis-PL-3

“de huizen van de man”

In (4) is er wel congruentie van persoon maar getalsovereenkomst is niet uitgedrukt in het possessieve affix omdat het getal van de bezitter al is uitgedrukt in het genitief nomen. We hebben dezelfde situatie als hierboven in het verbale domein: (5) kan niet “de mannen hun huis” betekenen. En de verklaring hiervoor is identiek. Maar in het nominale domein doet zich een extra mogelijkheid voor. Het ‘bezit’ kan zelf meervoudig zijn (5). De betekenis is uitsluitend “de man z’n huizen” en niet “de mannen hun huis.” Weer een dezelfde asymmetrie als in (2)/(3) maar met een twist. Om dezelfde reden als in (3) moet het ‘grammaticale’ -ler suffix op het bezitsnomen in (5) door een semantisch kenmerk op het bezittersnomen worden gevalideerd. Dat is er niet. Geen validatie dus. Daarom moet -ler een andere bestaansgrond hebben. Die is er. Het affix heeft namelijk het semantisch kenmerk (‘meervoud’) dat ev-ler de meervoudige betekenis ‘huizen’ geeft. Er is wèl persoonscongruentie: het suffix -i voor 3de persoon markeert congruentie tussen ‘huis’ en ‘man’ in het nominale domein (in het verbale domein is dit een nul-suffix). Bijgevolg voorspellen we dat evleri minstens tweevoudig ambigu moet zijn, namelijk “zijn huizen,” i.e., evler (‘huizen’) met possessive agreement -i (3.sg, ‘zijn’), en “hun huis,” i.e., ev (‘huis’) met possessive agreement -leri (3.pl, ‘hun’).

Een iets abstractere analyse geeft een principiële verklaring voor (2) en (4) en maakt duidelijk waarom (2) prevaleert boven (1). We nemen aan dat het suffix -ler/-lar meervoud uitdrukt en dat enkelvoud geen suffix kent. Het 3rde persoon suffix is -i op N maar een nul-morfeem op V. Met deze aannames worden (2) en (4) geanalyseerd als (6) en (7).

(6) adam-lar-ø-ø öl-dü-ø

N-PL-3-Case V-PST-3

adam-lar-3-NOM öl-dü-3

(7) adam-lar-ø-ın ev-i

N-PL-3-Case N-3

adam-lar-3-GEN. ev-3

In beide gevallen is er sprake van precies hetzelfde type congruentie. Spec-Head Agreement (SHAGR) werkt op persoonskenmerken in de structuur (8), waar X is N en Y is V of N. Naamval (Nom/Gen) is een reflectie van SHAGR.

(8) [YP X-PL-Prs-Case [Y-Prs … ]]

SHAGR(Prs) is een optie in agglutinerende talen waar persoon en getal ieder hun eigen affix-morfeem hebben. Voor flecterende talen is deze optie uitgesloten want persoon, getal, en soms ook geslacht zijn versmolten tot één morfeem. Vandaar de structuur ((Kind) –er) = ((N) 3.PL) voor Kind-er maar (((adam) -lar) 3) = ((N) PL) 3) voor adam-lar. SHAGR werkt op 3.PL in het flecterende Duits en alleen op 3 in het agglutinerendeTurks. Vergelijk die Kinder wart-et-en (V-PST-3.pl) met adamlar öl-dü (V-PST-3). Bovendien schenden de opties ?*adam-lar öl-dü-ler (“de mannen stierven”) en ?*adam-lar-ın ev-ler-i (“het huis van de mannen”) het eenvoudsbeginsel in agglutinerende talen omdat hier een zuiniger oplossing voor handen is, (2) adam-lar öl-dü respectievelijk (4) adam-lar-ın ev-i, die is uitgesloten in flecterende talen. Verbale suffixen voor getal /persoon zijn semantisch niet-interpreteerbaar en moeten daarom gevalideerd worden (bv. onder SHAGR zodat een correcte interpretatie en labeling tot stand komt). Aangezien suffigering van alléén persoon eenvoudiger is dan suffigering van persoon en van getal, is agreement op persoon alléén niet alleen voldoende maar ook noodzakelijk vanwege het zuinigheidsprincipe. Een oplossing met één affix is eenvoudiger dan een met twee. Daarom bv. (2) en niet (1). Dit universele principe is niet toepasbaar op flexie omdat hier getal en persoon tot één morfeem versmolten zijn. Hiermee zijn de verschillen tussen het Turks en Duits verklaard uit SMT-principes.

Samenhangende verbanden met taal-typologische en constructie-gebonden asymmetrieën zoals deze eisen een verklarend model met voldoende theoretische diepgang die hypothetisch-deductieve predicties mogelijk maakt. Congruentie is hier één factor in een geïntegreerd systeem van structuur-bouwende regels, agreement en labeling, en verklaart bv. de unificatie van EPP (“elke zin z’n subject”) en ECP (“gaten moeten identificeerbaar zijn”). Bijgevolg kunnen nul-subject talen geen expletief subject hebben en kunnen talen met een expletief subject geen nul-subject talen zijn, verklaringen die principieel buiten het bereik van LLM vallen met z’n ingebouwde beperkingen. Misschien kan Grambank hier een heuristische rol spelen. Maar database noch LLM kunnen deze empirische puzzels verklaren en nog minder een model impliceren van het menselijk taalvermogen. Het zou daarom beter zijn als DNN-technologie moderne inzichten van taal-theoretisch onderzoek zou weten te integreren.

Frederick Jelinek’s boutade “Every time I fire a linguist, the performance [of the model] goes up” zou heel goed ook hier kunnen gelden. Maar zij slaat bij nader inzien de plank mis. Het is niet de ‘performance’ die het primaire doel van AI zou moeten zijn maar het biologisch aangedreven systeem dat die ‘performance’ mogelijk maakt. Intelligent is de simulatie van de talige output, die vaak verbluffend accuraat is. Simulatie van het intelligente taalsysteem dat deze productie bepaalt ontbreekt echter. Vooralsnog lijkt het erop dat DNNs/LLMs intelligente updates zijn van Weizenbaum’s Eliza chatbot uit de beginjaren van AI. Die simuleerde een therapeutische output zonder bedoeling om een therapeutisch brein na te bootsen.

Maar een technologische taalrevolutie zonder inzicht in het menselijk taalvermogen mist een wetenschappelijk doel. En zonder doel kun je niet scoren.

Utrecht, 10 november 2024

Referenties

Bever, T., Chomsky, N., Fong, S., Piattelli-Palmarini, M. (2023) Even deeper problems with neural network models of language. Behavioral and Brain Sciences 46, e387 https://doi.org/10.1017/S0140525X23001619

Bowers, J.S., et al. (2023) Deep problems with neural network models of human vision. Behavioral and Brain Sciences 46, e385: 1–77. doi:10.1017/S0140525X22002813

Ceolin, A., Guardiano, C., Irimia, M.A., Longobardi, G. (2020) Formal syntax and deep history. Front. Psychol. 11:488871. doi: 10.3389/fpsyg.2020.488871

Ceolin, A., Guardiano, C., Longobardi, G., Irimia, M.A., Bortolussi, L., Sgarro, A. (2021) At the boundaries of syntactic prehistory. Phil. Trans. R. Soc. B 376: 20200197. https://doi.org/10.1098/rstb.2020.0197

Chomsky, N. (1981) Lectures on Government and Binding. Dordrecht: Foris Publications.

Chomsky, N. (2021) Minimalism: Where are we now, and where can we hope to go. Gengo Kenkyu 160, 1–41. doi: 10.11435/gengo.160.0_1

Horn, L. (1989) A Natural History of Negation. Chicago: University of Chicago Press.

Huybregts, M.A.C. (1979) De biologische kern van taal. In: R. Huybregts & L. des Tombe (eds.), Verkenningen in Taal. Utrecht: Instituut A.W. de Groot voor Algemene Taalwetenschap.

Irimia, M., Ceolin, A., Crisma, P., Guardiano, C., Kazakov, D., Longobardi, G. (te verschijnen) The Parametric Comparison Method: A linguistic introduction to deep history. In: G. Longobardi (ed.), The Oxford Handbook of Historical and Diachronic Linguistics. Oxford, UK: Oxford University Press.

Kandel, E.R, Koester, J.D., Mack, S.H., Siegelbaum, S.A. (2021) Principles of Neural Science (Sixth Edition). New York, NY: McGraw-Hill

Longobardi, G., Guardiano, C. (2009) Evidence for syntax as a signal of historical relatedness. Lingua 119(11), 1679-1706. doi:10.1016/j.lingua.2008.09.012

Longobardi, G., Guardiano, C. (2016) Parameter theory and parametric comparison. In: I. Roberts (ed.), The Oxford Handbook of UG. Oxford, UK: Oxford University Press, 377-401.

Luo X., Ramscar, M., Love, B.C. (2024) Beyond human-like processing: Large Language Models perform equivalently on forward and backward scientific text. arXiv:2411.11061v1 [cs.CL]

Moro, A. (2016) Impossible Languages. Cambridge, MA: MIT Press.

Musso, M., Moro, A., Glauche, V., Rijntjes, M., Reichenbach, J., Buechel, C., Weiler, C. (2003). Broca’s area and the language instinct. Nature Neuroscience 6(7), 774–781. doi:10.1038/nn1077

Roberts, I. (2019) Parameter Hierarchies and Universal Grammar. Oxford, UK: Oxford University Press.

Skirgård, H., et al. (2023) Grambank reveals the importance of genealogical constraints on linguistic diversity and highlights the impact of language loss. Science Advances 9(16), eadg6175 doi:10.1126/sciadv.adg6175

Yang, C. (2016) The Price of Linguistic Productivity. Cambridge, MA: MIT Press.

Yang, C., Crain, S., Berwick, R.C., Chomsky, N., Bolhuis, J.J. (2017) The growth of language: Universal Grammar, experience, and principles of computation. Neuroscience & Biobehavioral Reviews 81, 103–119.

Wij blijven Tussenmensen.

De fysische realiteit, de werkelijke-werkelijkheid, is echter geheel anders dan de werkelijkheid om ons heen; de omringende alledaagse werkelijkheid. Over de omringende werkelijkheid zijn biljoenen romans geschreven. Niet alleen de bioloog, fysicus en de neuroloog maken zich druk over de werkelijke werkelijkheid, maar ook de kunstenaar. Dat hoop ik tenminste. Niet alle kunstenaars en schrijvers natuurlijk. En niet op de laatste plaats mijn persoon maakt zich druk over de andere dimensies. Als het binnenbrein. Dimensies die nog geen onderwerpen zijn. Het is niet alleen fenomenologie, beleving. Het is ook wat je weet van de neurologische wetenschappelijke ontwikkelingen. Damasio bijvoorbeeld.

Laatst werd aan de schrijfster Marja Pruis tijdens de openbare lezing dit najaar aan de Rijksuniversiteit Groningen gevraagd: In welke dimensie bent u als u begint te schrijven. (Letterlijk weet ik het niet precies.) Haar antwoord? Ze wist hét niet. De taal had ze er ook niet voor. Ze had er nooit over nagedacht. Waar de taal vandaan komt, daar stond ze niet bij stil. Jammer, dacht ik want ik zat al op het puntje van de stoel en ik viel van verbazing van mijn stoel.

De schrijver wacht en als hét komt gaat het – vanuit het binnenbrein – schrijven, en als de schrijver is gaan schrijven komt de man met de hoge hoed die vertelt hoe de zinnen in correct Nederlands moeten staan; en wordt alras vergeten waardoor de schrijver begon met schrijven. Hét, … was er even en nu staan er keurige zinnen die de schrijver wil delen met de lezer. De homogeniteit is de troef. De lezer maakt er dan weer een ander taalpotje van.

Een mens is geen ding, want dingen zijn hanteerbaar en mensen zullen dit nooit zijn. Zelfs de meest onaangepaste mens. En stel je bent bioloog, fysicus of neuroloog en je bekijkt de mens vanuit de werkelijke werkelijkheid dan nog blijft de mens onhanteerbaar. Een monster soms. Een schrijver. Zelfs met al zijn taalcomplexiteit, kun je ook niets beginnen.

Het wordt tijd een nieuw en nauwkeurig mensbeeld in het schoolonderwijs te introduceren. Hoe? Weet ik niet.

Taalkundigen hoppen van de ene discipline naar de andere. Van de werkelijke werkelijkheid naar de werkelijkheid, naar het binnenbrein en weer terug. Je verzuipt in de woorden. Die woorden verhelderen niets, dan slechts miljoenen mogelijke verklaringen, die uitgelegd worden. Allemaal klopbaar.

Hoe staat het dan met de kunstenaar schrijver? ZHIJ zal zijn belevingen, zijn taalbeleving, – want feiten zijn het niet – die vanuit het binnenbrein ontstaan en in principe taalloos zijn, als schrijver eerlijker moeten gaan beschrijven. De taal zal daardoor evolueren en de taalkundige kan weer aan het werk.

Wij staan altijd tussen de werkelijke werkelijkheid en het binnenbrein in als tussenmens? Deze plaats zullen we nooit kunnen verlaten of begrijpen.

Binnenbrein (ook gebruikt om een deel van de hersenen aan te duiden) is een prachtig woord voor dat ongrijpbare deel van de betekenis. Tussenmens – dat vind ik een moeilijker begrip, want mens tussen wat?

Anneke Neijt, dankjewel voor de redactie. Ik had de beleving dat Tussenmens zich bevindt tussen het binnenbrein en de werkelijke werkelijkheid in. Dat gebied heet het bewustzijn. (Rob van Essen noemt het binnenbrein een witte of lege kaart?!) Dat is het dus niet. Het is een drift die taal opwekt. Rob wordt er door aangezet om te schrijven.

https://www.ensie.nl/nwn/tussenmens

Mooi overzicht. Je maakt goed duidelijk dat AI geen antwoord geeft op de vraag wat taal eigenlijk is. AI simuleert menselijke uitingen, niet het taalvermogen van de mens. Echt leuk dat je ‘nalles’ en ‘noveral’ noemt (je artikel staat in de DBNL), geinig dat artikel van Luo et al. (2024) waaruit blijkt dat de omgekeerde volgorde even goed werkt en heldere uitleg van het verschil tussen agreement en betekenisdragende morfologie.

Het verklarende vermogen van de computersystemen lijkt vooralsnog nihil. Af en toe bekruipt me het gevoel dat ChatGPT alleen maar zo goed functioneert omdat het een systeem is dat geschreven taal gebruikt. Bizar toch, zonder informatie over prosodie, mimiek enz. Kennelijk leveren letters, interpunctie en spaties al heel wat informatie. Maar beslist onvoldoende om rare kronkelredeneringen te voorkomen, wat blijkt als je aan Chat een waarom-vraag stelt.

Terechte kritiek heb je op de Grambank. Het gaat om een ononderbouwde set van vragen (voelt aan als een schot hagel) die beantwoord worden aan de hand van overzichtswerken zoals Donaldsons beschrijving van het Nederlands (niet de Algemene Nederlandse Spraakkunst!). De Grambank ontwijkt de echte vraag die je als taalkundige wilt beantwoorden, namelijk wat zegt de verzameling van vormen over de betekenis en over het systeem dat daarachter zit?

Bij enkele stellingen heb ik wel meer toelichting nodig..

(1) Derde alinea: “Taal ontwikkelt zich zonder incrementele inductie.” Misschien te algemeen gesteld? Zou er geen enkel stadium van taalontwikkeling zijn waar incrementele inductie een rol speelt? Het is denkbaar dat jonggeborenen het onderscheid tussen hoofd en afhankelijke afleiden (deduceren) uit de melodische structuur van taal. Het gaat altijd om meer of minder duur, hoger of lager van toon. Die tweedeling zit in het aanbod. Blijft de vraag waarom mensenkinderen daar wel betekenis aan toekennen (wel hoofd en afhankelijke gaan onderscheiden), en baby’s van apen dat niet doen. Dat er een aangeboren taalvermogen is, dat zal niemand ontkennen. Maar het is denkbaar dat het taalvermogen slechts die aandrang is om vorm en betekenis te koppelen.

(2) Vijfde alinea: “Bijvoorbeeld. Taal kent hiërarchische structuur terwijl probabilistische DNNs (die zich met name baseren op dependency grammar of construction grammar) de lineaire structuur van woordreeksen als input krijgen.” Als de input van DNN’s slechts de lineaire structuur van woordreeksen is, dan komt er geen dependency grammar of construction grammar aan te pas, toch? DNN’s zijn dan implementaties van het aloude idee van syntagma’s op basis waarvan je paradigma’s kunt vormen. Maar misschien sla ik hier de plank mis.